Facebook Reality Labs опубликовала подробное исследование метода создания гиперреалистичных виртуальных аватаров в реальном времени, подробно остановившись на предыдущей работе, которую компания называет «Codec Avatars».

Facebook Reality Labs создала систему, способную анимировать виртуальные аватары в режиме реального времени с беспрецедентной точностью благодаря компактному оборудованию. Всего из трех стандартных камер в гарнитуре, которые фиксируют глаза и рот пользователя, система способна более точно отображать нюансы сложных жестов лица конкретного человека, чем предыдущие методы.

Смысл исследования заключается не только в прикреплении камер к гарнитуре, но и в «технической магии», лежащей в основе использования входящих изображений для виртуального представления пользователя.

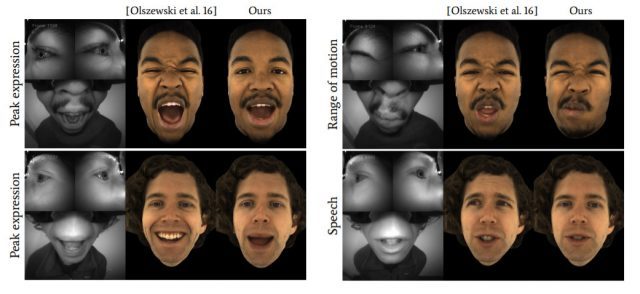

Решение в значительной степени опирается на машинное обучение и компьютерное зрение. «Наша система работает в режиме реального времени и с широким спектром выражений, включая надутые щеки, прикус губ, движение языком и такими деталями, как морщины, которые трудно точно воспроизвести с помощью предыдущих методов», — говорит один из авторов.

Facebook Reality Labs опубликовала техническое видео-резюме работы для SIGGRAPH 2019:

Группа также опубликовала свою полную исследовательскую работу, которая еще глубже погружается в методологию системы. Работа под названием «Анимация лица с помощью виртуальной реальности с применением Multiview Image Translation» была опубликована в ACM Transactions on Graphics. Авторы статьи — Ши-Эн Вэй, Джейсон Сарагих, Томас Саймон, Адам У. Харли, Стивен Ломбарди, Михал Пердок, Александр Хайпс, Давэй Ван, Эрнан Бадино, Язер Шейх.

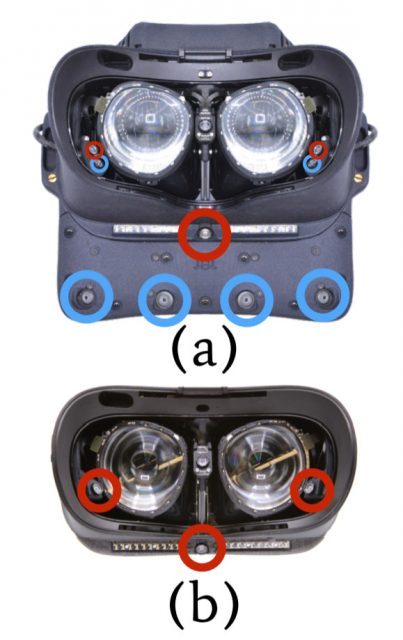

(а) Гарнитура «Обучение» с девятью камерами. (б) Трекинговая гарнитура с тремя камерами; положения камеры, используемые для тренировочной гарнитуры, обведены красным.

(а) Гарнитура «Обучение» с девятью камерами. (б) Трекинговая гарнитура с тремя камерами; положения камеры, используемые для тренировочной гарнитуры, обведены красным.

В документе объясняется, как проект включал создание двух отдельных экспериментальных гарнитур, гарнитуры «Обучение» и гарнитуры «Отслеживание».

Тренировочная гарнитура имеет большую громкость и использует девять камер, которые позволяют ей захватывать более широкий диапазон взглядов лица и глаз субъекта. Это облегчает задачу поиска «соответствия» между входными изображениями и ранее снятым цифровым сканированием пользователя (решение о том, какие части входных изображений представляют какие части аватара). В документе говорится, что этот процесс «автоматически обнаруживается путем самостоятельного перевода многовидовых изображений, который не требует ручных аннотаций или однозначного соответствия между доменами».

После установления соответствия можно использовать более компактную гарнитуру «Отслеживание». Выравнивание трех камер отражает три из девяти камер на гарнитуре «Обучение». Виды этих трех камер лучше понятны благодаря данным, собранным с гарнитуры «Обучение», что позволяет вводу точно управлять анимацией аватара.

В документе основное внимание уделяется точности системы. Предыдущие методы создают реалистичный результат, но точность фактического лица пользователя по сравнению с представлением нарушается в ключевых областях, особенно с экстремальными выражениями и взаимосвязью между тем, что делают глаза, и тем, что делает рот.

Каким бы впечатляющим ни был этот подход, он все еще сталкивается с серьезными трудностями, препятствующими развитию технологии. Опора как на детальное предварительное сканирование пользователя, так и на начальную необходимость использования гарнитуры «Обучение» потребует чего-то такого же, что и «центры сканирования», куда пользователи могут отправиться на сканирование и обучение своего аватара. Пока VR не станет значительной социализирующей частью общества, маловероятно, что такие центры будут жизнеспособными. Тем не менее, передовые технологии зондирования и постоянные улучшения в построении автоматической корреспонденции на пике этой работы могут в конечном итоге привести к жизнеспособности этого процесса в домашних условиях. Вопрос остаётся один: когда это произойдёт…?